【实用Docker项目】使用 ollama 部署本地语言模型

本文最后更新于 2024-05-14,

若内容或图片失效,请留言反馈。部分素材来自网络,若不小心影响到您的利益, 请联系我 删除。

本站只有Telegram群组为唯一交流群组, 点击加入

文章内容有误?申请成为本站文章修订者或作者? 向站长提出申请

什么是 ollama?

运行Llama 3、Phi 3、Mistral、Gemma和其他模型。定制并创建您自己的模型。

为什么选择 ollama?

- 能直接运行大模型,与大模型进行对话。

- ollama 命令具有管理大模型的能力。

- 利用 cpu 运行大模型。

- 本地大模型安全可靠。

- 终端直接开始聊天。

- 社区提供了支持 web api 方式访问 WebUI。

如果你还没有尝试过在本地部署过大模型,那么 ollama 非常适合你。建议搭配WebUI一起使用

准备工作

- docker 为了方便部署软件。

- 存储空间充足的机器,一般来说参数越大,需要配置越好。

- 良好的网络环境。

安装Docker🐳

安装 ollama

进入 ollama 下载页面,选择自己的系统版本的下载并安装即可。

检验是否安装成功

输入 Ollama 命令,正常的得出命令行输出,表示已经安装成功,下面有 ollama 的常用命令:

ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

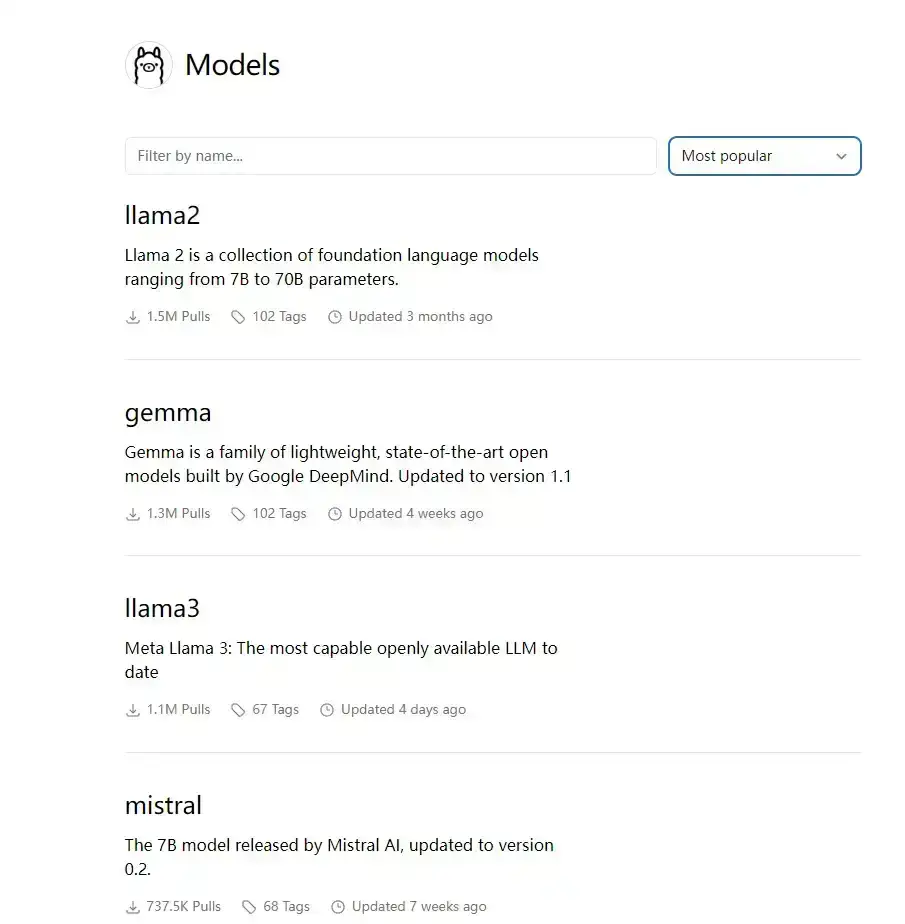

ollama 模型库

我们可以在 https://ollama.com/library 中搜索已有我们想要的模型库。以下是一些流行的模型:

| 模型 | 参数 | 尺寸 | 执行下载 |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

这里大概列出了 Llama、Mistral 以及 Gemma 我们景见的模型以及参数以及尺寸大小。由图表可以看出 Gemma 2B 模型的尺寸还是比较小的,初学者入门。

运行模型

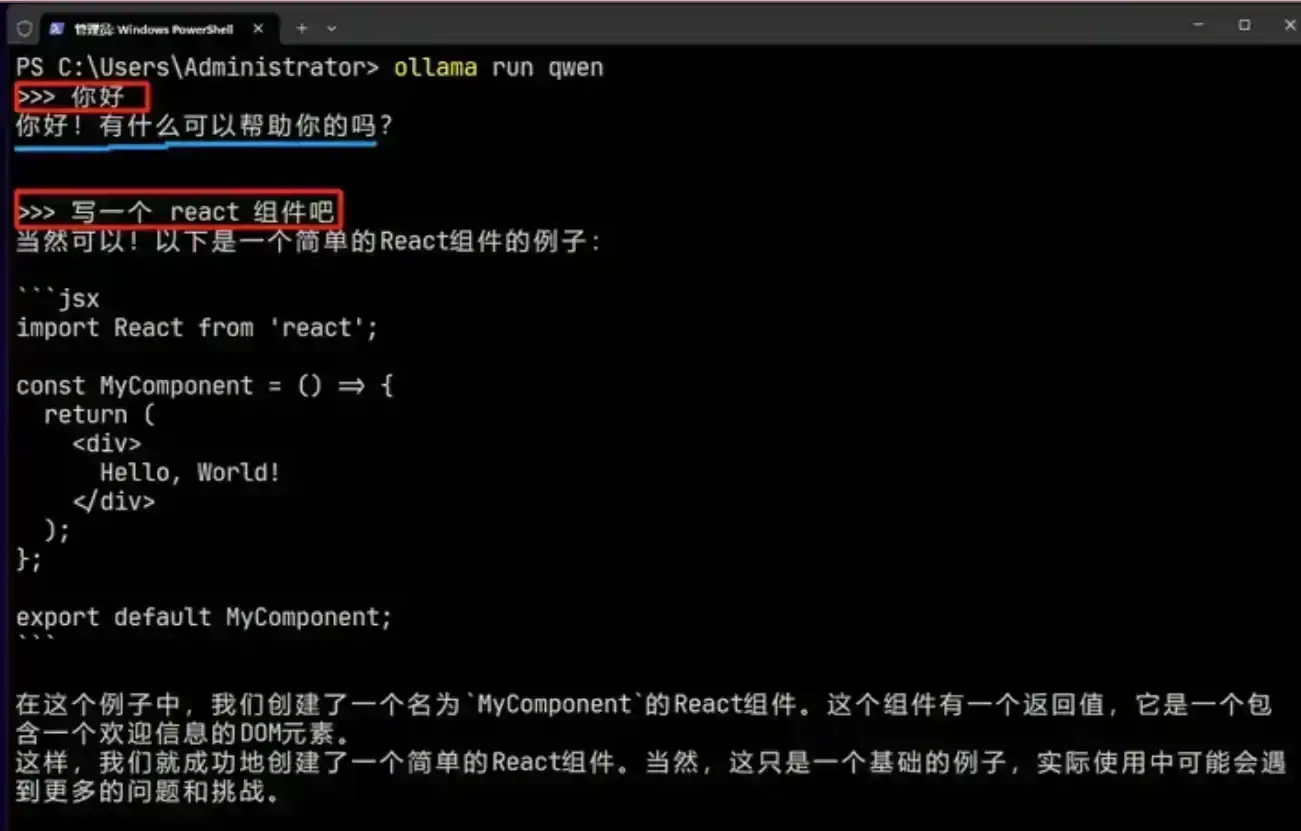

ollama run qwen # 运行千问大模型

因为qwen 模型对中文支持比较好,这里使用 qwen 模型进行聊天

直接使用 run 命令 + 模型名字就可以运行模型。如果之前没有下载过,那么会自动下载。下载完毕之后可以在终端中直接进行对话 qwen 模型了。

直接在终端中对话:用 ollama 千问模型写一个 React 组件

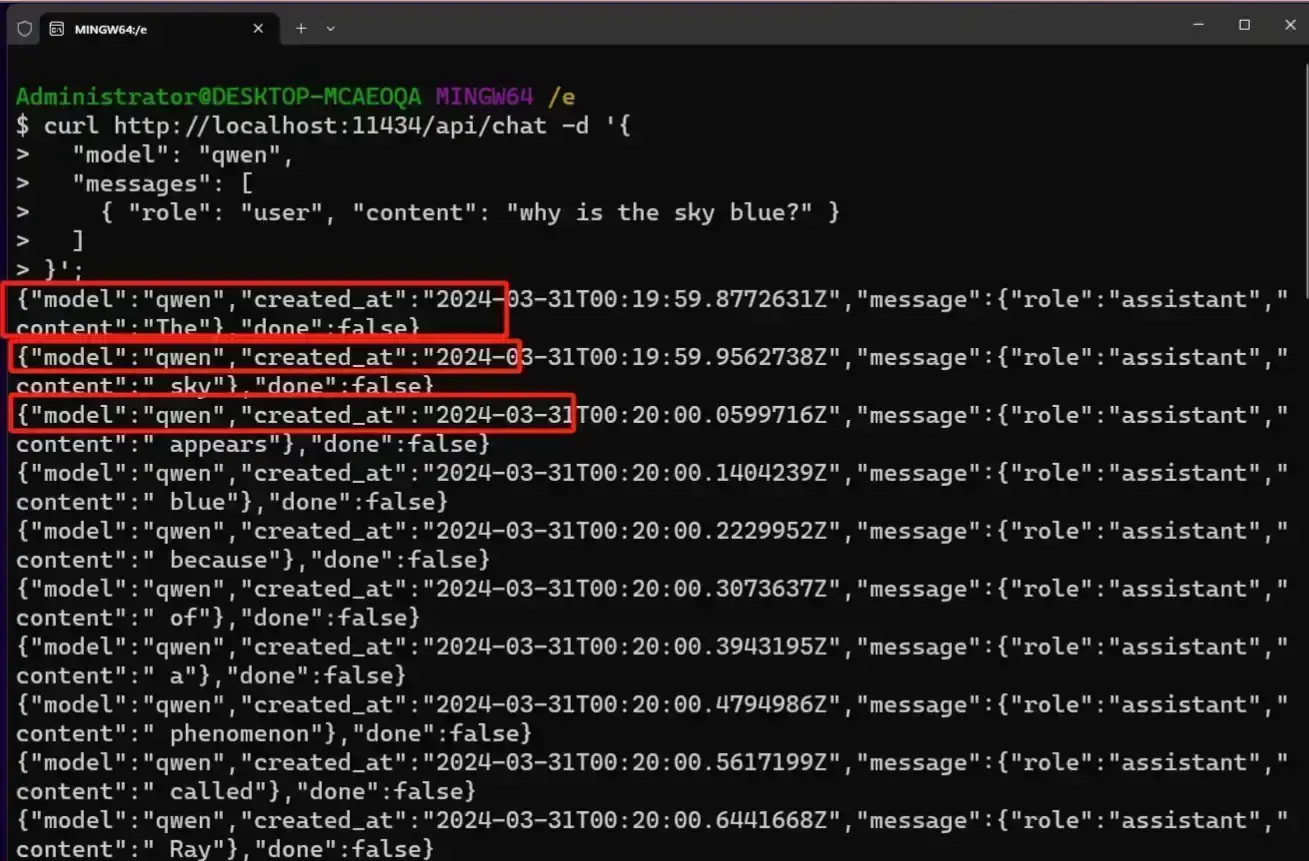

使用 api 方式运行

curl http://localhost:11434/api/chat -d '{

"model": "qwen",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

api 访问的方式:模型在不断推送字段。我们需要自己处理。

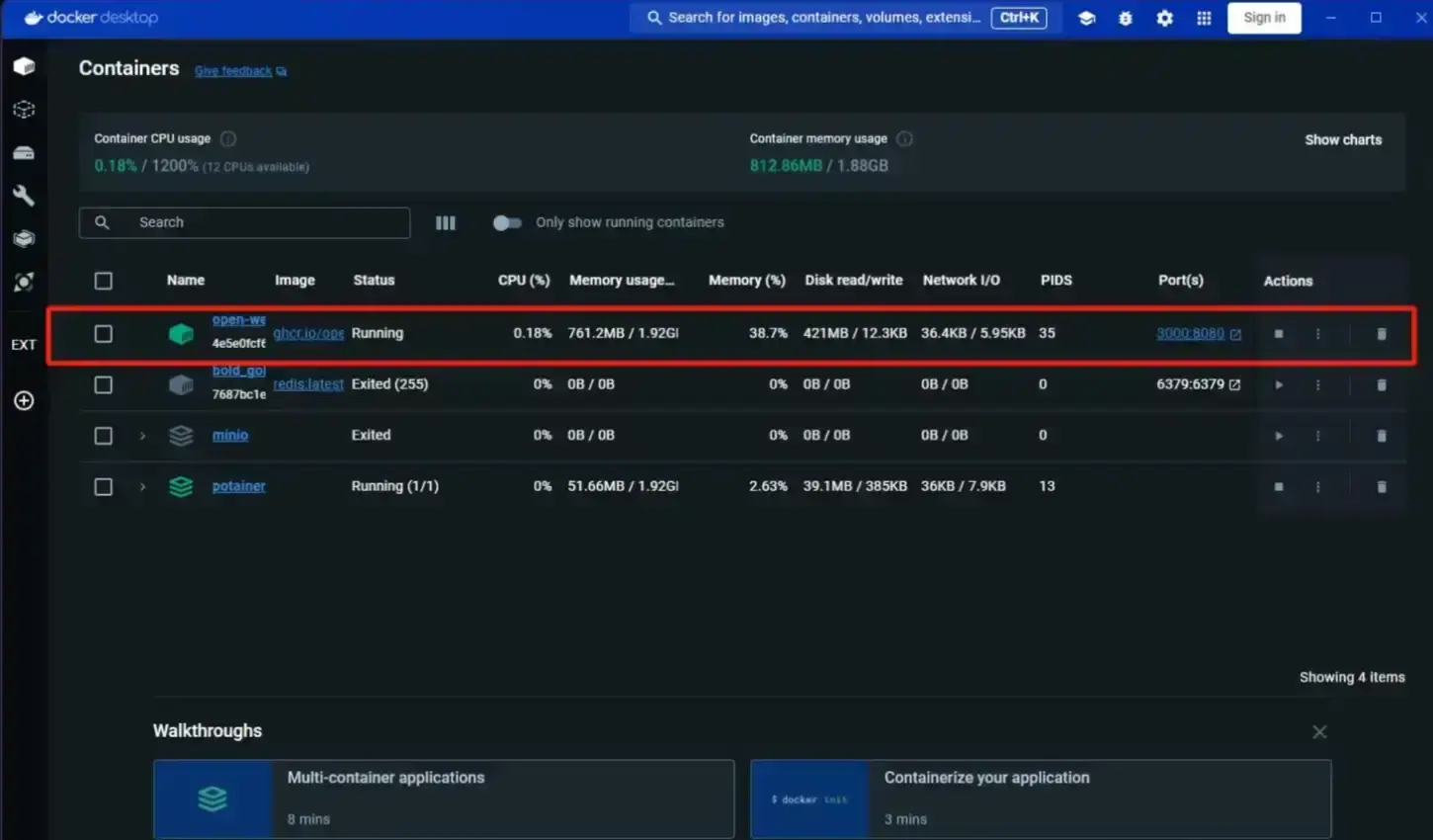

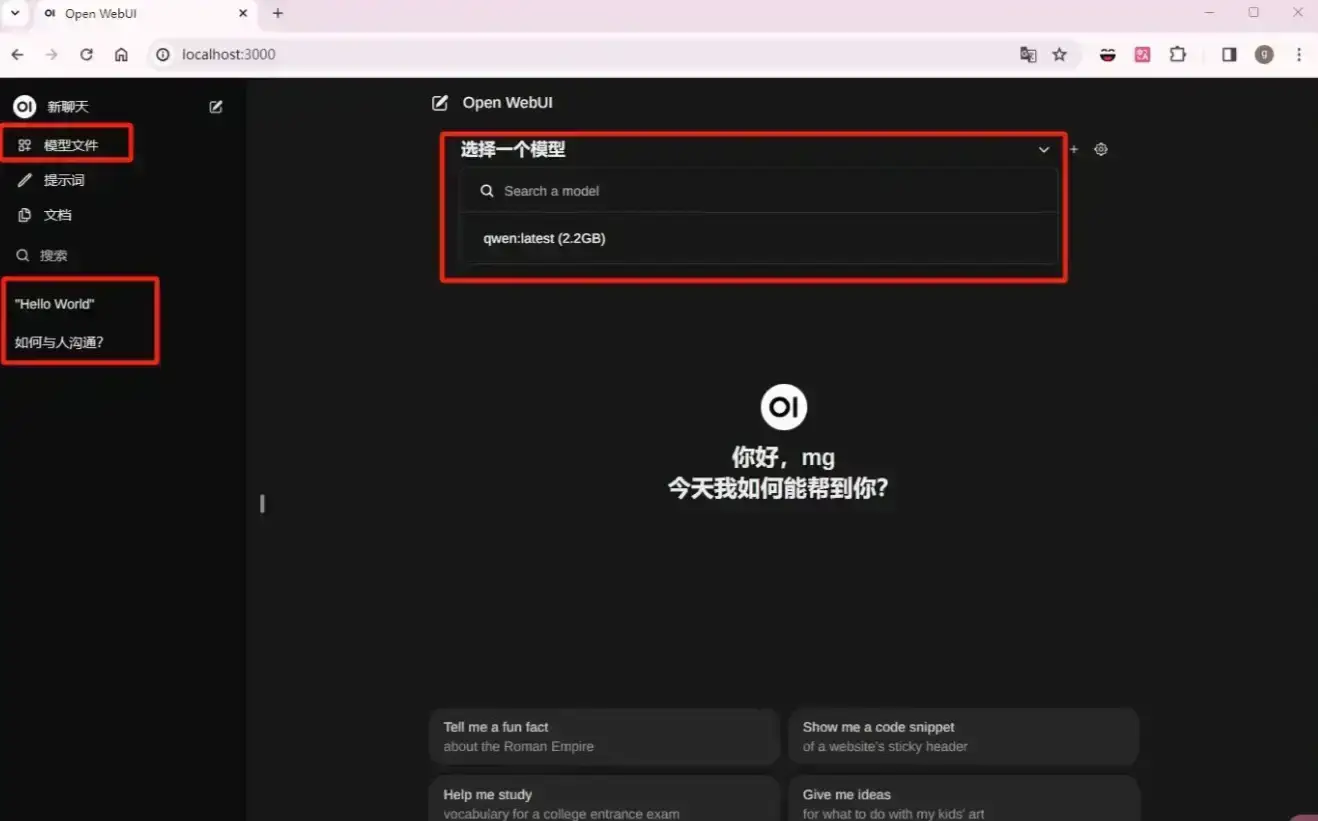

推荐 Open WebUI

LLMs用户友好的WebUI(以前的Ollama WebUI)

相关安装文章 https://poiblog.com/archives/c0CaQGFx

使用 docker 可以方便的部署

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data

注意 3000 时长被其他的开发程序占用,使用需要注意自己的端口是否被占用。

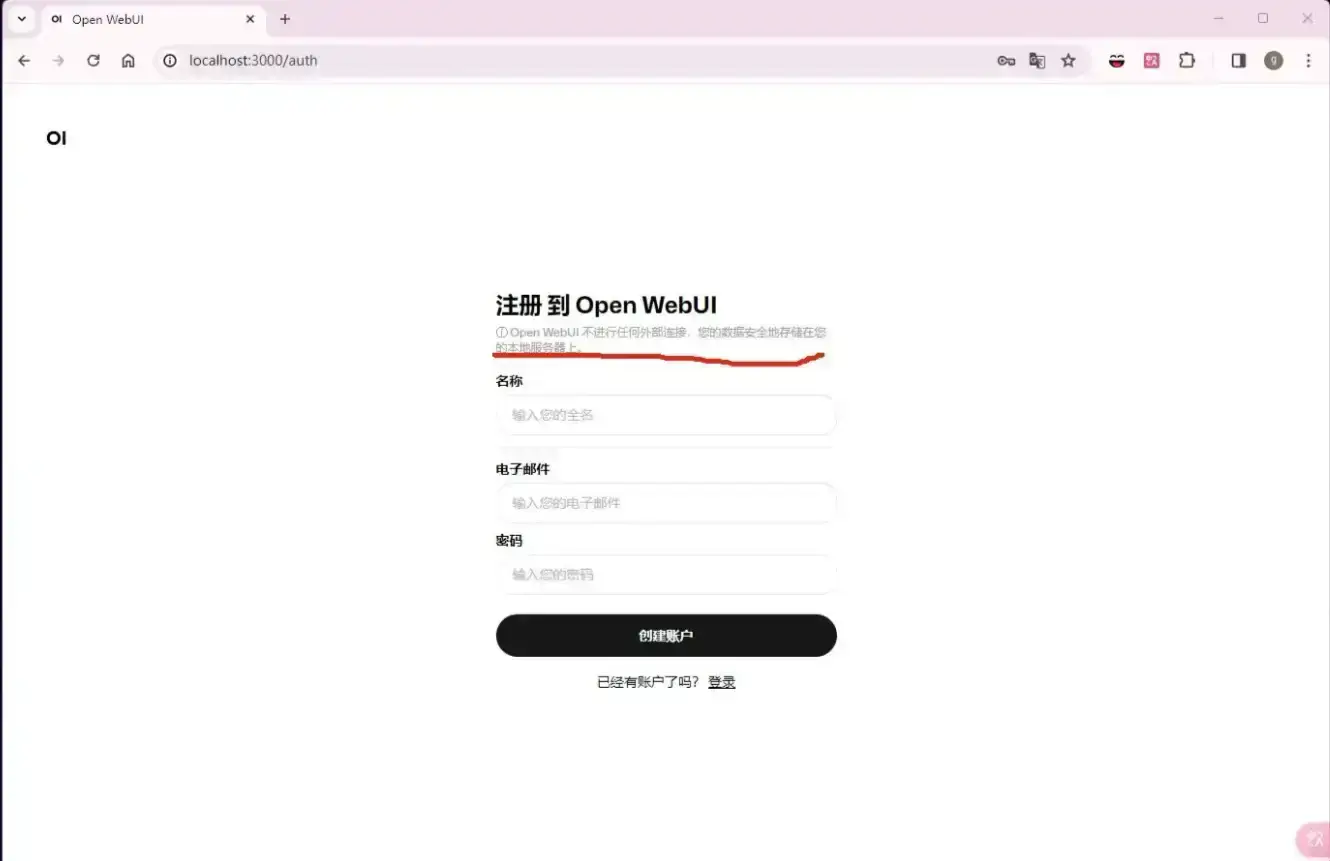

注册

Open WebUI 聊天界面

反向代理

参考教程:安装及使用

⚠️Nginx Proxy Manager(以下简称NPM)会用到80、443端口,所以本机不能占用(比如原来就有Nginx)

互联网使用请确保完成了域名解析